Что такое мета роботы?

- Для чего он используется?

- Атрибут содержимого: Директивы

- заключение

- Элемент ссылки «канонический»

- Управление параметрами в Google Search Console

- заключение

Мета-роботы - это HTML-метатег, который служит для того, чтобы давать указания паукам поисковых систем относительно отслеживания и индексации веб-страницы, на которой он реализован. С целью роботов мы даем руководящие указания индексировать или не указывать страницу, или следовать или не ссылаться на другие страницы, предотвращая их отслеживание.

Для чего он используется?

Цель роботов позволяет вам контролировать, как страница должна быть проиндексирована и как отображать ее пользователям на странице результатов поиска.

Его обычное использование применяется для указания отрицательных директив, потому что трекер понимает их как положительные, если не указано иное. По умолчанию они уже интерпретируются как положительные.

Это очевидно, но мы не должны указывать какие-либо метатеги роботов, если мы хотим, чтобы поисковые системы проиндексировали страницу. Вот почему мы должны быть очень осторожны, чтобы не включать и не удалять их на тех порталах, которые используют их в тестах и которые собираются запустить финальную версию, которую они хотят проиндексировать, чтобы отслеживание осуществлялось без проблем.

Расположение мета-роботов должно быть сделано в разделе <head> рассматриваемой страницы.

Кроме того, он должен содержать два атрибута, имя и содержимое для правильной работы.

<! DOCTYPE html>

<Html>

<Голова>

...

<title> ... </ title>

<meta name = "robots" content = "noindex" />

...

</ head>

<Body>

...

</ body>

</ html>

Атрибут содержимого: Директивы

Значения, которые могут сопровождать метатег робота для предоставления различных указаний относительно формы индексации или публикации страницы, могут быть несколькими и указываться в атрибуте «контент» .

Мы можем дать столько руководящих указаний, сколько сочтем уместным, при условии, что, если они включены, они разделяются запятыми.

- index / noindex: с помощью которого мы будем указывать сканерам, хотим ли мы проиндексировать или нет веб-страницу в их поисковых системах, чтобы она появлялась или не появлялась в результатах поиска тех же самых. Если мы не хотим индексировать его, с помощью noindex мы скажем вам не показывать эту страницу в ваших результатах.

- follow / nofollow: сообщает пауку, должен ли он отслеживать и следовать или нет ссылкам, содержащимся на рассматриваемой странице.

- archive / noarchive , указывает, хотим ли мы, чтобы робот мог сохранять содержимое веб-страницы во внутреннем кеше поисковой системы или нет.

- фрагмент / nosnippet: чтобы в результатах поиска отображалось только название, а не описание.

- odp / noodp: когда мы не хотим, чтобы поисковые системы извлекали метаданные из Open Project Directory, в заголовки или описания страниц, которые отображаются в результатах. (В общем, подразумевается, что эта директива устарела, потому что Open Directory Project Directory вышел из употребления).

- ydir / noydir , аналогично предыдущему, но для каталога Yahoo! (В целом понятно, что эта директива устарела, поскольку каталог Yahoo! вышел из употребления).

- переводить / не переводить : предлагать или нет перевод страницы в результатах поиска.

- noimageindex : не индексировать изображения на странице.

- unavailable_after [RFC-850 date / time] : когда мы не хотим, чтобы страница отображалась в результатах поиска с указанной даты и времени.

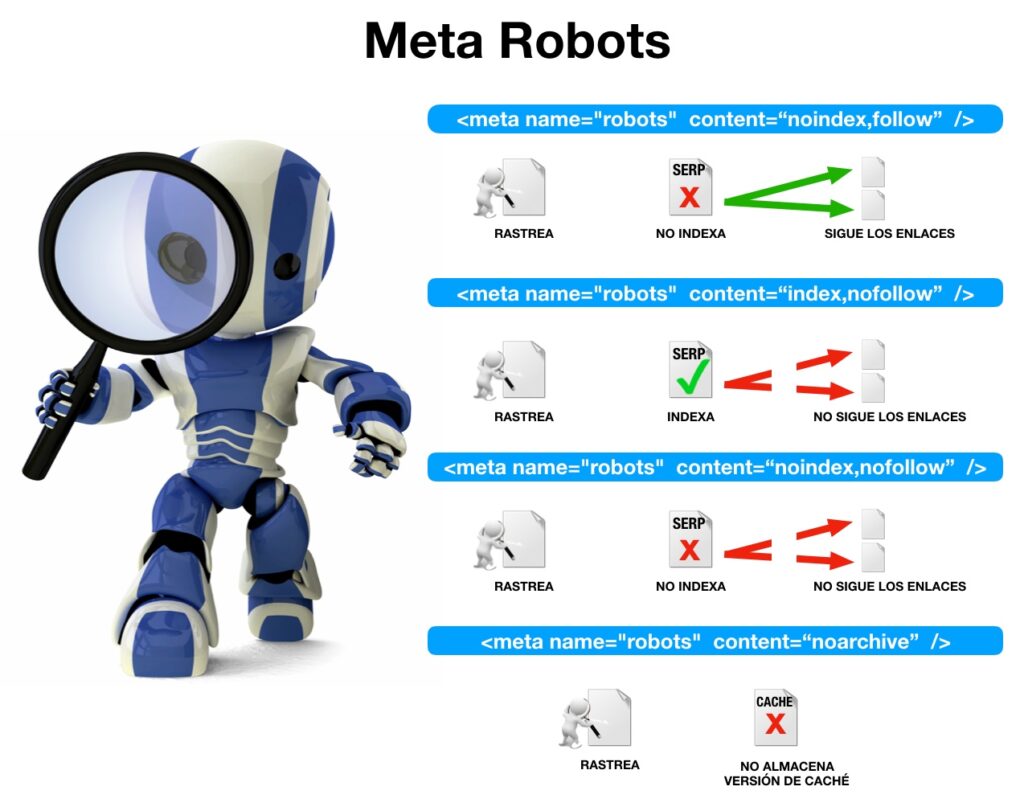

Мы приводим несколько примеров мета-роботов и значение того, что мы хотим сказать поисковым движкам:

<meta name = " robots " content = " index, follow " />

Это метка по умолчанию для любой веб-страницы, и нет необходимости включать ее. Скажите сканеру сканировать, индексировать и переходить по ссылкам, содержащимся на веб-странице. Это не нужно, потому что это поведение по умолчанию для любого робота.

<meta name = " robots " content = " index, nofollow " />

Мы хотим, чтобы страница была проиндексирована, но ссылки, содержащиеся на ней, не отслеживаются. Обычно он включается, когда мы не хотим, чтобы связанные страницы были проиндексированы либо путем блокировки метатегом robots с помощью директивы noindex, либо путем блокировки инструкции «disallow» из файла robots.txt.

<meta name = " robots " content = " noindex, follow " />

В этом случае мы хотим, чтобы страница, содержащая цель, не была проиндексирована, но мы хотим, чтобы робот обнаруживал и отслеживал связанные с ней страницы. Обычно он включается в постраничные результаты, когда количество страниц в серии очень велико.

<meta name = " robots " content = " nofollow, noodp " />

Когда мы хотим, чтобы содержащиеся в нем ссылки не отслеживались, и мы не хотим показывать метаданные opda в заголовках или описаниях страницы.

Как мета-роботы, так и директивы, указанные в файл robots.txt нашего веб-сайта может дать нам некоторый контроль над тем, какие страницы следует индексировать и / или отслеживать, а какие - нет . Хотя, по-видимому, это два метода, направленных на достижение одной и той же цели, выбор того или иного уровня SEO будет зависеть от сценария и конкретной цели.

Чтобы понять различия, важно различать отслеживание и индексирование , При сканировании поисковики получают доступ к контенту и «читают» информацию, содержащую страницу . Впоследствии поисковая система решает проиндексировать этот контент в той или иной категории поиска или не индексировать его вообще . Если поисковая система не отслеживает страницу, мы экономим время отслеживания и оптимизируем «скорость сканирования», оставляя роботу больше времени для отслеживания наиболее важного или текущего содержимого. Если, с другой стороны, робот сканирует контент, но затем не индексирует его, этот контент также не появится в результатах, но мы потратим драгоценное время на «скорость сканирования», которое мы могли бы использовать в своих интересах.

Когда они получают доступ к новому веб-сайту, роботы поисковых систем пытаются найти файл robots.txt, чтобы ознакомиться с указанными в нем директивами. Если URL-адрес соответствует одному из шаблонов, указанных как недопустимые («запрещать») в файле robots.txt, робот просто проигнорирует URL-адрес и не будет индексировать его. Это означает, что Google не придется тратить время на сканирование контента, который мы не хотим индексировать.

Если, с другой стороны, робот Google обнаруживает метатег роботов в URL-адресе, это означает, что вам пришлось просматривать и сканировать эту страницу . Если в метатеге робота мы указываем, что не хотим индексировать страницу с помощью директивы noindex, Google также не будет показывать этот контент в результатах.

По-видимому, мы достигли той же цели: запретить Google показывать определенные URL-адреса в своих результатах. Но использование ресурсов Google отличается . С файлом robots.txt ему не нужно было обращаться к URL-адресу или сканировать его содержимое, в то время как с метатегом robots ему приходилось тратить некоторое время на его отслеживание.

С другой стороны, файл robots.txt дает нам большую гибкость, когда речь идет об определении шаблонов URL, которые мы не хотим, чтобы Google сканировал, тогда как мета-роботы контролируют URL-адресацию для индексации URL-адресов .

Хотя директива «запрещать» в файле robots.txt не позволит Google получить доступ к определенному URL-адресу по ссылке на нашем собственном веб-сайте, Google все же может «обнаружить» и сканировать этот URL-адрес, если найдет ссылку, указывающую на него. с другого сайта, то есть внешней ссылки. По этой причине мы можем обнаружить URL-адреса, для которых Google не показывает никакого описания при поиске по сайту: domain.com.

Напротив, метатеги-роботы с директивой noindex приведут к тому, что Google перестанет полностью показывать этот URL в своих результатах . Google будет сканировать URL, но не будет добавлять его в свой индекс (подчиняясь этой инструкции "noindex").

заключение

Если мы запретим сканирование URL-адреса в файле robots.txt, поисковые системы не будут тратить время на отслеживание этого контента, если они не обнаружат его по внешней ссылке, поэтому мы можем оптимизировать время, которое робот посвящает отслеживанию нашего контента, но не это настолько эффективный метод, если мы не хотим, чтобы ни при каких обстоятельствах страница отображалась в результатах .

Если мы запретим индексирование URL-адреса из метатега робота, Google не будет индексировать этот URL-адрес и никогда не будет показывать его в своих результатах , но мы потратим впустую драгоценное время на отслеживание паука.

В дополнение к метатегам robots и файлу robots.txt существуют и другие способы управления индексацией страниц на веб-сайте. Как например:

Элемент ссылки «канонический»

Когда мы указываем элемент ссылки «канонический» Мы предлагаем поисковой системе, с какого URL мы хотим, чтобы вы проиндексировали указанное содержание. Этот URL-адрес может быть точно таким же, как и тот, который осуществлял доступ к контенту (каноническая ссылка на себя) или канонической странице, или он может быть другим, и в этом случае мы будем говорить о канонизированном URL-адресе. В этом последнем случае мы можем указать Google, что он не индексирует разные URL-адреса для контента, который может быть обнаружен как дубликат, например списки контента, упорядоченные по разным критериям, варианты одного и того же продукта в разных цветах или размерах и т. Д.

Хотя необходимо учитывать, что для поисковых систем «канонический» является лишь предположением . Если поисковая система находит значительное количество внутренних или внешних ссылок на определенный URL-адрес, она, вероятно, будет индексировать его, даже если он канонизирован по другому URL-адресу (то есть даже если он содержит «канонический» элемент ссылки, указывающий на другую страницу).

Управление параметрами в Google Search Console

Еще один способ контролировать индексирование или нет определенных URL-адресов в разделе Управление параметрами инструмента Google Search Console , С его помощью мы можем указать, какие параметры должны быть проиндексированы в URL (например, номера идентификаторов продуктов), а какие (например, параметры отслеживания кампании или переупорядочение контента).

заключение

Как «канонический» элемент ссылки, так и управление параметрами в Google Search Console являются методами, позволяющими избежать индексации URL-адресов, что может привести к потенциальной проблеме дублированного контента. Когда это возможно, рекомендуется быть последовательными в определении канонических URL-адресов и в спецификации, составленной из управления параметрами Google Search Console, поскольку, хотя эта функция направлена на предотвращение индексации дублированного контента, важно понимать различные эффекты, которые мы достигаем с каждым из методов управления индексированием, чтобы применить соответствующий в нашем конкретном сценарии.

Похожие

Что такое SEO?Отличный вопрос Чтобы понять SEO, вам нужно понимать поисковые системы. Поисковая система - это часть программного обеспечения, которая сканирует Интернет и индексирует свои страницы, чтобы предоставить лучшие рекомендации веб-сайтов на основе поискового запроса пользователя. И они используют сложные, постоянно меняющиеся Что такое Google Пингвин?

Когда Google вносит серьезные изменения в свой алгоритм, они часто дают ему имя. В апреле 2012 года Google произвел серьезное обновление своего обычного алгоритма ранжирования поиска, получившего название «Пингвин». Цель обновления Google «Пингвин» состоит в том, чтобы… ждать его… веб-спам! Вероятные цели обновления - сайты, нарушающие Рекомендации Google по качеству для веб-мастеров (сайты, участвующие в заполнении ключевых слов, схемах ссылок и различных других видах чрезмерной Природные ссылки

SEO или SEO (поисковая оптимизация) - одна из основ интернет-маркетинга. Долгосрочная стратегия, естественная привязка позволяет получить видимость . Хорошее позиционирование вашего сайта в результатах поисковых Что такое SEO: понять основы

Как насчет начала с самого начала? Это содержание только для ниндзя, которые начали свой путь сейчас, но стремятся достичь полноты. Сегодня вы узнаете, что такое SEO. Для тех, кто уже имеет некоторые знания в этой области, я рекомендую поискать наше промежуточное содержание. Что такое SEO? Во-первых, SEO является Что такое естественные ссылки?

SEO Естественное - это широко распространенное понятие, но оно остается неясным для многих. Эта статья поможет вам понять, что 17 инструментов Google, полезных для SEO и веб-мастеров

Сегодня трудно представить Интернет-пространство без Google. Благодаря этому пользователи могут найти практически любую информацию без особых усилий. Самое главное - правильно сформулировать свой запрос. В дополнение к обычному поиску Google Что такое SEO и зачем оно вам?

Поисковая оптимизация (SEO) - это процесс оптимизации сайта, чтобы он хорошо работал в обычном поиске. Высокий рейтинг поисковых запросов, известных как ключевые слова, увеличивает видимость сайта и приводит к увеличению числа посетителей реального сайта. Проще говоря, SEO позволит вам связаться с теми, кто ищет ваш продукт или услугу, и поможет превратить их в клиентов. Как владелец бизнеса, вы должны иметь план для продвижения вашего бизнеса и привлечения новых клиентов. SEO позиционирование по Google

Выделенный IP-адрес - больше преимуществ SEO

Поисковая оптимизация - это искусство. Чем выше у вас рейтинг в Google, тем больше у вас возможностей продавать свой продукт или услуги в Интернете. Эксперты SEO продолжают экспериментировать на сайтах с каждым аспектом, чтобы получить их на более высоких позициях и лидах. Одной из областей является то, приносит ли выделенный IP-адрес больше пользы для SEO по сравнению с общим IP-адресом? Что такое общий IP-адрес? Как упоминалось ранее, сервер, который ваш веб-хост использует Мета Описание Увеличение длины: что это значит для SEO

В декабре 2017 года Google подтвердил, что у них есть расширено ограничение длины мета описания от 160 символов до 320 символов. Это расширение фрагмента результатов поиска означает, что маркетинговые команды теперь имеют двойные символы, видимые в списках страниц результатов поиска. Мета-описание, расположенное под URL-адресом и тегом мета-заголовка, является способом показать 10 бесплатных инструментов Google для SEO оптимизации

Если вы считаете себя маркетологом контента, SEO-маркетологом или онлайн-маркетологом, индустрия цифрового маркетинга имеет типичные отношения любви и ненависти с Google. Тем не менее, независимо от того, что вы думаете о большой G, есть множество бесплатных инструментов, которые приходят со значительно полезными данными. При разумном использовании они, безусловно, могут помочь ускорить ваши усилия по цифровому маркетингу. К сожалению, у Google есть постоянная привычка либо отзывать пару

Комментарии

Что такое SEO и что такое профессиональный специалист делает это?Не говоришь по испански? Прочитайте этот пост на английском , На прошлой неделе мы снова посетили SEO-клинику eShow в Барселоне. В этом случае мы использовали методологию, которая, как мы знали, понравится многим SEO. Мы объясняем необходимые Google только что опубликовал свои аккаунты за последний квартал 2011 года: в последнем квартале 2011 года поступило 6 277 миллионов евро , Кто-нибудь сомневался, что Google был бизнесом?

Не говоришь по испански? Прочитайте этот пост на английском , На прошлой неделе мы снова посетили SEO-клинику eShow в Барселоне. В этом случае мы использовали методологию, которая, как мы знали, понравится многим SEO. Мы объясняем необходимые Что делают ваши конкуренты или что они не делают, и что вы можете сделать лучше?

Что делают ваши конкуренты или что они не делают, и что вы можете сделать лучше? Чтобы вы выделялись и становились лучше конкурентов, вам нужно знать, как они работают. Проще говоря: вы не можете избежать анализа конкуренции. Нарисуйте своих самых важных конкурентов для этого (как минимум три должны быть). Анализ конкуренции включает в себя анализ ключевых слов и обзор опубликованных статей ваших конкурентов, а также лучшие статьи в топ-10 результатов поиска. Ориентируйтесь Что такое естественные ссылки?

Что такое естественные ссылки? SEO - это механизм, который позволяет поисковым системам сортировать результаты поиска по запросу . Таким образом, если вы выполняете поиск «Туризм» в поисковой системе, он оценит все веб-сайты, которые могут вас заинтересовать, и классифицирует их, чтобы предложить вам результаты, которые он считает наиболее подходящими для вас . SEO бесплатно , мы не можем платить поисковым системам, чтобы Что произойдет, если они не найдут то, что им нужно на вашем сайте (потому что ничего не найти)?

Что произойдет, если они не найдут то, что им нужно на вашем сайте (потому что ничего не найти)? Они разочаровываются. И слово путешествует быстро в эти дни. Если достаточное количество посетителей будет разочаровано, другие об этом узнают, и, естественно, люди перестанут влюбляться в трюк с ключевыми словами. Google просто обошел весь этот естественный процесс и избавил людей от многих хлопот. Это сделало ваш контент центром внимания, и это правильно. Люди читают хороший контент, а Теперь, как насчет использования Без спешки наблюдать за тем, что делают конкуренты, какие слова индексируют и что вкладывают в рекламные ссылки ?

Что произойдет, если они не найдут то, что им нужно на вашем сайте (потому что ничего не найти)? Они разочаровываются. И слово путешествует быстро в эти дни. Если достаточное количество посетителей будет разочаровано, другие об этом узнают, и, естественно, люди перестанут влюбляться в трюк с ключевыми словами. Google просто обошел весь этот естественный процесс и избавил людей от многих хлопот. Это сделало ваш контент центром внимания, и это правильно. Люди читают хороший контент, а Что такое управление сканированием и почему это важно?

Что такое управление сканированием и почему это важно? Crawl management описывает усилия оптимизаторов по контролю за тем, как поисковые системы сканируют свои сайты, включая страницы, которые они читают, и то, как они перемещаются по сайту. Поисковые пауки могут входить и выходить из домена в любом порядке. Они могут попасть на ваш сайт через случайную страницу продукта и выйти через вашу домашнюю страницу. Однако, как только паук попал на ваш сайт, вы хотите убедиться, Что вы испытываете при использовании расширений с Google Chrome для нынешних пользователей Chrome, замедляет ли он браузер?

Что вы испытываете при использовании расширений с Google Chrome для нынешних пользователей Chrome, замедляет ли он браузер? Большое отличие этого инструмента заключается в том, что с его помощью вы можете находить предложения по ключевым словам, а не только думать о поиске, выполненном в Google , Что ты имеешь ввиду?

Что вы испытываете при использовании расширений с Google Chrome для нынешних пользователей Chrome, замедляет ли он браузер? Что такое Google Speed Update?

Что такое Google Speed Update? Несмотря на то, что в AdWords нет изображений, Google также активно инвестирует в изображения ваших брендов и продуктов. Это называется обновлением скорости. И есть 2 вещи, которые замедляют скорость загрузки страницы: Слишком много JavaScript часто вызвано слишком большим количеством приложений и недостаточно встроенным на ваш сайт. Слишком большие изображения, которые не оптимизированы под размер 8. Что такое хорошее управление доменом?

8. Что такое хорошее управление доменом? Это общий вопрос. Что такое высокий авторитет домена? Конечно, ответ «это зависит». В частности, это зависит от конкуренции за фразу. Думайте об этом как о спортивном счете. Какой хороший результат в спорте? 40 хороший результат? Это зависит от спорта. Оценка 40, и вы выиграете каждую хоккейную игру Счет 40 выиграет большинство футбольных игр

Для чего он используется?

Для чего он используется?

Что такое SEO?

Одной из областей является то, приносит ли выделенный IP-адрес больше пользы для SEO по сравнению с общим IP-адресом?

Что такое общий IP-адрес?

Не говоришь по испански?

Не говоришь по испански?

Что делают ваши конкуренты или что они не делают, и что вы можете сделать лучше?

Что такое естественные ссылки?

Что произойдет, если они не найдут то, что им нужно на вашем сайте (потому что ничего не найти)?